中国のAIスタートアップDeepSeekが、数学問題に特化した新たな大規模モデル「DeepSeek-Prover-V2-671B」をHuggingface上で公開した。前モデルの「Prover V1.5」が7B(70億パラメータ)であったのに対し、今回のV2はその約100倍となる671B(6710億パラメータ)へと大幅にスケールアップ。モデルアーキテクチャはDeepSeek-V3をベースに、MoE(Mixture of Experts)構造を採用し、Transformer層は61層、隠れ層サイズは7168、最大トークン長は163840と、超長文コンテキストにも対応する設計となっている。

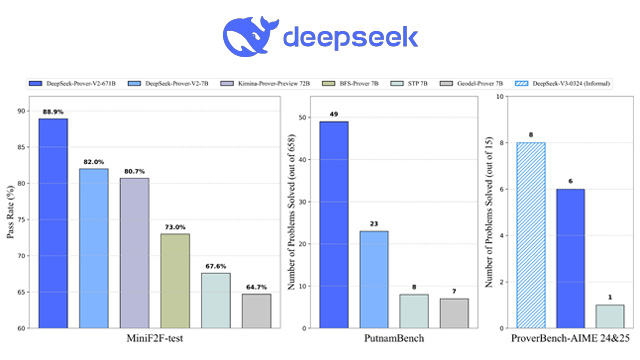

モデルはMITライセンスで公開されており、誰でも無料で使用・改変・再配布・商用利用が可能。Huggingface上での公開直後から注目を集め、ランキングでも急速に上位へ浮上している。現在のところベンチマークスコアなどの詳細な評価は明らかにされていないが、専門家の間では「数学分野で世界トップ3に食い込む可能性がある」との声も上がる。

モデル名にある「Prover(証明者)」は、形式論理や対話型証明システムにおいて真偽を示す側の役割を意味し、数学における厳密な論理推論を意識した命名だ。DeepSeekはこのProverモデルを通じて、AGI(汎用人工知能)の基礎技術として数学力の強化に挑戦している。

OpenAIのGPT-4ベース「o3」が博士レベルに達したとされる中で、DeepSeekはV3ベースの微調整でそれに迫るレベルを実現し、AIの知能強化において中国勢の実力を再び証明した格好となった。