バイトダンス傘下のSeedチームは、次世代の通用ロボット向け大規模モデル「GR-3」を公開した。GR-3は視覚・言語・動作を統合したVision-Language-Action(VLA)モデルであり、わずかな人間データによるファインチューニングで多様な環境・物体に対応する高い汎化能力を持つ。指令の解釈には抽象的な言語理解も含み、従来のルールベースでは困難だった指示にも正確に応答可能だ。

GR-3はMixture-of-Transformers構造を採用し、視覚と言語の入力から動作の生成までを一貫して処理。アクション生成にはDiffusion Transformerを使用し、高精度な動作シーケンスを実現している。また、学習には従来のロボットデータに加え、VRを使った人間の操作軌跡、さらには公開図像と言語データも統合。これにより、未見物体への対応や抽象概念の理解といった従来課題の克服に成功した。

ロボット本体の「ByteMini」は、22自由度と独自の球形手首関節を持ち、狭い空間でも高精度な操作が可能。さらにWBC(全身運動制御)システムによって、動作は滑らかで柔軟。複数のカメラで細部と全体を同時に捉える設計も、家庭内作業での実用性を高めている。

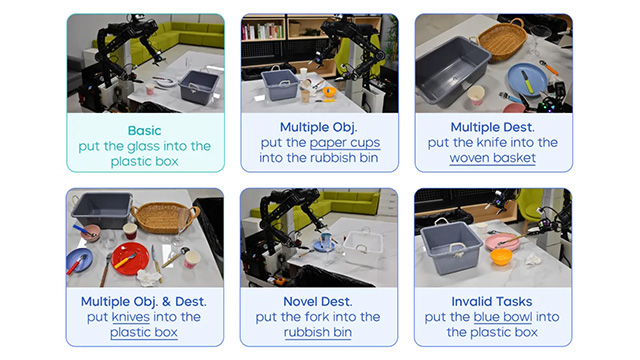

実験では、GR-3は「未見環境での物体把持」「柔軟物体操作(衣類のハンガー掛け)」「抽象言語指令に基づく多段階作業(テーブル清掃)」といったタスクで、業界標準モデルを上回る性能を示した。特にVRで取得した10本の軌跡データ追加により、未見物体の成功率は60%未満から80%以上に上昇するなど、人間データの効果も明確に示された。

将来的には、さらなる汎化性の向上に向けてモデル規模とデータ多様性を拡大するとともに、強化学習の導入で模倣学習の限界を克服する方針だ。GR-3は単なる作業モデルにとどまらず、「家庭内通用ロボット大脳」としての将来像を志向している。