アリババ傘下の研究機関Tongyi Labは、推理性能を大幅に強化した大規模言語モデル「Qwen3-235B-A22B-Thinking-2507(以下、Thinking-2507)」を正式公開した。本モデルは、Qwen3-235Bをベースに設計された思考特化型バージョンであり、コード生成や数学推論、創作能力、多言語理解など多方面において最高水準の性能を示した。

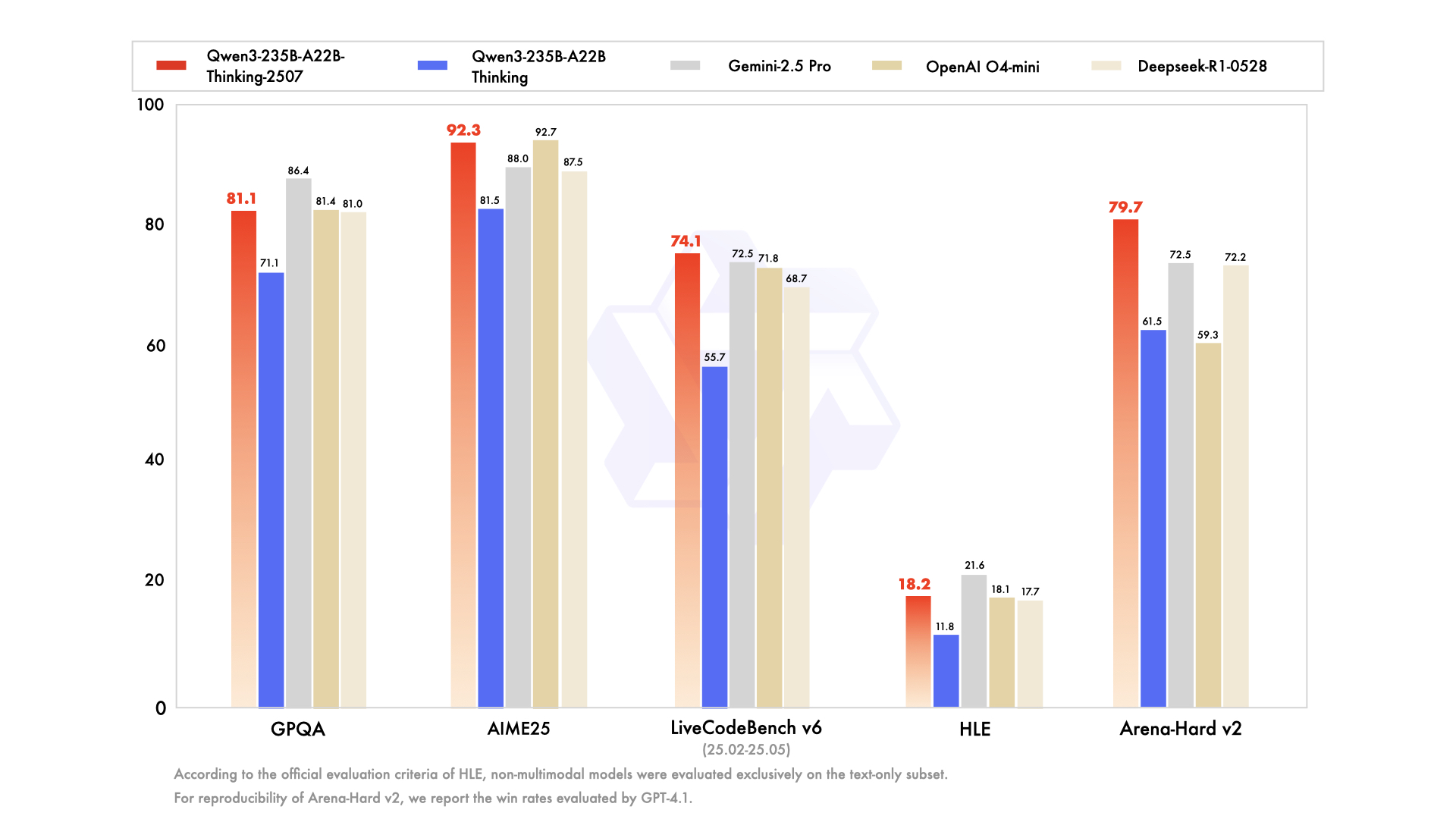

特に、LiveCodeBench(プログラミング)やAIME25(数学)ではSOTAを更新。さらに、WritingBench(創造的ライティング)、Arena-Hard v2(人間の好みに即した応答性)、SuperGPQA(知識)、MultilF(多言語)などのベンチマークにおいても目覚ましい進化を遂げている。

Thinking-2507は、最大256Kトークンという超長文コンテキストに対応し、大規模ドキュメントの要約や複雑な対話に強みを発揮。実用性とスケーラビリティの両立を実現している。

モデルはApache 2.0ライセンスで提供され、誰でも自由にダウンロード・商用利用が可能。Hugging Faceに掲載された比較では、GoogleのGemini 2.5 ProやOpenAIのGPT-4 miniと同等レベルに位置づけられ、オープンソースLLMとしての完成度が評価されている。